从图形渲染到密集计算 通用GPU的崛起

CPU迎战Fermi,纳入新的协处理机制

如果事态就这么自然地发展,Fermi将不断蚕食原本属于CPU的领地—其实它本来就是CPU中的浮点运算单元,只不过变得异乎寻常的强大而已。加上NVIDIA摆脱了通用标准的制约,形成一个强大的封闭平台,这样将会与Intel的CPU中心平台和AMD的双线兼顾平台,形成角度不同的三国鼎立。

很显然,像Off ice办公软件、Web浏览器、IM即时通讯这样的商务软件不会消耗多少CPU资源,再低端的处理器都可以很好地运行这类整数运算任务。假如不是Flash帮忙,高性能CPU的用处实在是非常小了。不过,Adobe的Flash现在也在支持CUDA平台,利用GPU进行加速,微软的IE9也加入了GPU加速,倘若诸如交互动画和网络视频这些消耗CPU大的应用都依赖GPU运行,那我们还需要高性能CPU来做什么呢?

Intel如日中天的背后,潜藏着这样的危机,应用形态的改变完全可能颠覆整个产业,在短短的时间内将彻底改变产业形态。作为半导体业首屈一指的巨头,Intel显然不会坐以待毙,实际上,早在数年前提出的Many-Core“众核”计划便是针对此种未来而准备。

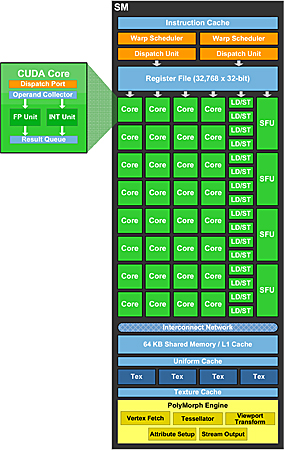

Many-Core采用主处理器+协处理器的设计思想,主处理器便是我们常说的CPU,协处理器则是拥有特殊功能的计算逻辑,比如高清视频加速、Java解释执行、Flash硬件加速等。每一个协处理器都执行特定的应用,而那些应用如果由CPU来完成的话就会非常低效。在Intel的初蓝图中,Many-Core将在2010年后开始被导入,不过迄今为止Intel还没有这方面的行动,这未免让它显得落伍。如果与Fermi对比,我们发现Intel的Many-Core虽然结构完全不同,但是思想殊途同归:都是由专用部件来完成CPU所不擅长的任务,所不同的是Many-Core只是Intel过去的远景构想,不幸的是实现这个构想的却是NVIDIA的Fermi。

Fermi以另一种方式实现了Intel的梦想,并开创了一个全新的应用领域

在新发布的Core i3处理器中,我们看到图形核心被集成于处理器芯片内,不过这种整合只不过是“积木游戏”,对性能与应用没有任何的影响力。虽然Larrabee计划的失败看起来轻描淡写,但实际上完全可能会令Intel陷入一场突如其来的重大危机。

与Intel相比,AMD在CPU方面反而没有这种压力,这完全得益于来自ATI图形部门的贡献。AMD不会有改变CPU构造的动机,它的目标比较务实,只要能够从Intel手中不断抢夺市场份额,企业能够正面增长就没问题,哪怕自身缺乏改变未来的宏图大志。毕竟对于一家被糟糕的财务压垮多年的半导体企业,我们委实不应苛求太多。

现在,Adobe Flash和其它交互网页是CPU的后堡垒,我们有理由相信,在未来的三年内,所有Flash元素都会实现GPU加速,同时,3D游戏对CPU的依赖将继续减弱,如果没有高负载的任务来接手,高性能CPU的市场将会缩小,这对于传统CPU厂商来说是可怕的前景。