触摸海量存储的技术之光

近听到很多“终结硬盘”的消息。没错,在SSD硬盘兴起之后,传统的温彻斯特式机械硬盘地位受到了挑战,特别在硬盘的速度和存取性能方面。不过机械硬盘也不是一成不变的老古董。从机械硬盘诞生到现在,有大量的新技术不停地被提出,一部分被淹没在历史的尘埃中,一部分则得到了市场和消费者的青睐。今天我们就要向大家介绍近一段时间以来机械硬盘技术发展的新进展。它们中的一些已经应用到生产中,而另一些技术尚在设计之中。

近听到很多“终结硬盘”的消息。没错,在SSD硬盘兴起之后,传统的温彻斯特式机械硬盘地位受到了挑战,特别在硬盘的速度和存取性能方面。不过机械硬盘也不是一成不变的老古董。从机械硬盘诞生到现在,有大量的新技术不停地被提出,一部分被淹没在历史的尘埃中,一部分则得到了市场和消费者的青睐。今天我们就要向大家介绍近一段时间以来机械硬盘技术发展的新进展。它们中的一些已经应用到生产中,而另一些技术尚在设计之中。

硬盘(以下特指机械硬盘)作为电脑中主要的数据存储设备,容量和速度一直备受瞩目。在采用了垂直记录技术以后,硬盘的单碟容量从100GB左右飞速发展到600GB。不过随着硬盘磁记录单元体积的进一步缩小和超顺磁效应的出现,硬盘的容量发展遇到了瓶颈。硬盘的重要参数之一,每平方英寸数据密度的上升空间越来越有限了。

每平方英寸数据密度和硬盘容量的提升、硬盘继续维持较高的容量/价格比,以及硬盘数据传输速度的提升都息息相关。首先,每平方英寸数据密度能够影响到3.5英寸和2.5英寸硬盘的大数据存储容量。简而言之,如果你想买到3.5英寸的10TB硬盘,唯一办法就是尽可能的提高每平方英寸的数据密度。

其次,硬盘的价格和容量有关系,但从生产角度来看,每个硬盘内的磁盘数量是决定硬盘成本主要的因素,如果能用更少的盘片存储更多的数据,那么硬盘的容量/价格比将会持续上升。我们可以看到,在单碟160GB时代,160GB硬盘售价是300多元,在单碟500GB技术普及以后,500GB硬盘的售价也在300元左右。此时的容量/价格比相比之前上升了很多,未来还会维持这种上升态势。

第三,硬盘的内部传输速度和硬盘的每平方英寸数据密度相关。所谓内部传输速度,是指在理想状态下,硬盘将数据从磁盘上持续地转移到数据I/O接口的能力。如果每平方英寸的数据密度越高,磁盘在同样的转速下旋转时磁头得到的数据就越多,可以显而易见地提高内部传输速度。现在,大部分的问题都指向一点—每平方英寸的数据密度。为了温彻斯特硬盘的持续性发展,科学家们需要尽可能地提高硬盘的每平方英寸数据密度。

空间利用更有效——改进硬盘数据存储方式的高级格式化技术

在描述怎样才能提高硬盘每平方英寸数据密度之前,我们先来了解一项号称能够提升硬盘10%左右容量的新技术。该新技术相当于变相提升数据存储密度,这就是近很火热、已经被应用在实际产品上的高级格式化技术(Advanced Format)。

在电脑刚兴起的年代,硬盘的容量并不大,6.4GB的硬盘就可以称之为海量。因此选择512byte作为一个数据小节也是比较恰当的。但后来伴随着硬盘的容量从几GB一路增长到1TB甚至2TB—在进入TB时代后,传统的数据存储方式就出现了一些不必要的浪费。

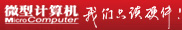

传统格式化硬盘的数据存放方式和高级格式化技术存放方式的对比

我们假设有10GB的文件,如果按照512byte一个小节来划分的话,每一个小节不仅需要小容量的Sync/DAM区域,还需要配备40byte的ECC区域。如果仅考虑ECC文件空间,那么每次数据记录时,附加文件的体积大约需要占据整个存储空间的40÷(512+40)=7.2%。也就是说,我们存储10GB的内容,不考虑Sync/DAM区域和其他间隙扇区(Sector Gap),需要至少732MB的空间来存放校验内容,实际额外耗费的硬盘空间甚至在1GB左右。

而高级格式化技术的大特点在于将每个数据小节的容量由512byte扩大到4kB。为什么选择4kB呢?首先,X86计算机的内存分页就是4kB;其次,一些磁盘文件系统格式如NTFS等,每一个数据簇都是4kB;第三,微软的新操作系统直接支持4kB读取。选择4kB意味着一个数据节就可以存储整个内存分页文件和一个文件数据簇,非常方便。

在高级格式化技术将小节扩大到4kB后,ECC空间也相应扩大到100byte。如果仅考虑ECC文件空间,那么每次数据记录时,附加文件的体积大约占据100÷(4×1024+100)=2.3%。大大缩小了附加文件占据的体积。如果此时存储10GB的文件,多耗费硬盘空间(考虑Sync/DAM区域和其他间隙扇区在内)大约在300MB~400MB左右,相比之前的1GB左右节省了不少。

需要注意的是,这里所说的空间节省,是指在硬盘制造过程中,能够有效利用的空间更大,容易生产出单碟容量更高的硬盘,这种空间节省并不会明显增加硬盘的容量,凭空多出10%的空间的事情几乎不存在。此外,高级格式化技术在使用中还存在一定的问题,主要体现在对老的系统如Windows XP兼容性不好,需要使用硬跳线或者软件方法校准数据。当然,高级格式化技术还能够提升硬盘的纠错效率、格式化效率以及可靠性。总的来说,这项技术对硬盘厂商的意义远大于消费者,因为消费者购买的1TB容量的硬盘不大可能凭空变成1.1TB容量。目前采用高级格式化技术的主要是西数的绿盘系列硬盘,例如WD20EARS。

硬盘格式化都包含哪些内容?

所谓格式化,是为硬盘上存储数据的空间画好区域,便于用户操作时存放数据。既然有高级格式化,肯定有“传统格式化”。“传统格式化”在管理硬盘时,会将整个文件划分为很多很多个小节。每个小节存储的文件数据大小为512byte。有读者就要问了,这么多小节存放起来不是很麻烦吗?数据的连贯性和正确性怎么保证呢?为了解决这个问题,科学家为每小节都添加了一个Sync/DAM区域,用于保证数据的连贯性;另外,还有一个校验区域,用于保证512byte数据的正确性。在这里,你可以把硬盘存储数据的方式想象成火车。每一个数据小节都是一节车厢,这节车厢为了和前后车厢连接,肯定会有接头,接头部分就是Sync/DAM区域。为了保证每节车箱内的东西不被偷,还需要找一个专门的看护人员,这就是校验区域。

温度的正向利用——热辅助磁记录技术

硬盘的发展需要更高的每平方英寸数据密度,但在实际应用中,还有很多困扰需要解决。为了增大数据密度,科学家们就需要使用更小的空间来存放数据。在2004年,存放一位数据,大约需要100个磁畴。虽然目前没有确切的数据表明存放一位数据需要多少个磁畴,但确信远比2004年时低。

磁畴更少,意味着每个存放数据的磁记录单元越小。所谓磁记录单元,是一个小颗粒,由很多磁畴组成,它们紧紧地抱成一团,可以通过表现磁性来储存数据。在实际使用中,每一个磁记录单元都能存储1bit数据。在当前技术下,过小的磁记录单元的后果是存储性能不够稳定,其中主要原因是超顺磁效应。

为了解决这个问题,在实际使用中必须使用小体积下磁性更稳定的磁材料,用专业术语来说就是必须使用“高矫顽力”的材料。矫顽力是什么意思呢?矫顽力是磁材料保有磁性的能力,换句话来说:如果有一块磁铁,你想消去它的磁性时,必须给它附加的磁场强度。

高矫顽力的材料的特点就是保有磁性的能力特别强,抵抗外界磁场的能力也很厉害,如果想让这种材料失去磁性就得附加更高的磁场才行,同时高矫顽力材料对温度和体积的抵抗性也变得更强,超顺磁效应也变得更为不明显。高矫顽力材料的使用,让磁记录单元有了进一步缩小的可能,就能进一步提高数据存储密度。但高矫顽力材料给硬盘磁头本身读写带来了问题。由于使用了高矫顽力材料,硬盘本身磁头也需要更强的磁性才能写入数据。但磁头就这么大,并且还有越来越小的趋势,很难进一步加强磁场了。除此之外,硬盘的磁头还存在聚焦精度问题。目前的硬盘磁场聚焦使用了类似于针的磁头细尖端,并且磁记录单元进一步缩小后,磁头的细尖端也很难精确聚焦磁场。

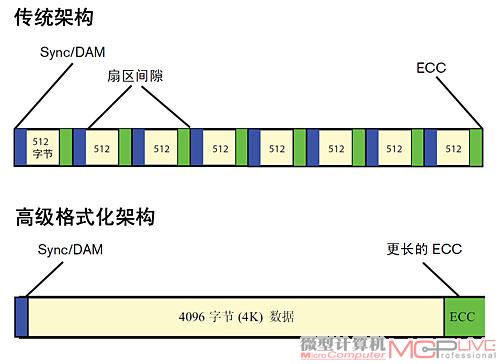

怎么样才能让存储数据的磁记录单元在不丧失高矫顽力的情况下,更容易被磁场改变呢?这似乎是一个矛盾,但也有一把钥匙可以解决,这就是温度。我们知道,磁铁在高温下都容易失去磁性,矫顽力会下降。因此,如果找到一种办法,能精确地对每一个需要改变的磁记录单元温度进行人为干涉,就能很轻松地继续增加数据密度。在多次试验和探索后,科学家们将眼光集中到激光上来。激光聚焦后可以加热很细微的区域,并且聚焦精度远比磁聚焦高得多。因此,目前的热辅助磁记录技术,就有了如下的运作过程:1.硬盘根据系统的需求,移动磁头到需要写数据的位置;2.打开激光加热设备,将需要读写的磁记录单元预先加热;3.控制磁头磁场强度,让磁场强度恰好可以改变需要写入部位的磁记录单元的极性;4.完成读写,磁头移动寻找下一个目标磁记录单元。

热辅助磁记录技术运作示意图

上述过程看起来非常简单,实际上是极为复杂的。原本的硬盘只需要具备磁头改变磁记录单元的性质,但新的方法需要另外一套加热的激光设备来辅助运行。其中就出现了很多问题:这套新的加热设备耐用度如何?精确度足够吗?是否能长久运行?有没有可能出现误加热?除此之外,被激光加热的磁记录单元虽然很小,加热时间也很短,但长时间使用后的累计热量还是不容忽视的。对磁记录单元来说,加热的磁记录单元必须通过磁盘的基板散热,不能将热量传导至邻近的磁记录单元,否则将有可能造成误写入,这也对整个磁盘的加热算法提出了极高的要求。另外,目前的材料需要600摄氏度的高温才能降低矫顽力,这显然是很难接受的。为了尽可能达到安全稳定的目的,必须降低材料的写入温度。科学家们已经寻找到一些新材料,能够将温度从600摄氏度左右降低至330摄氏度。但这还不够,如果能进一步降低,这项技术的实用性才可能大大提升。

总的来看,热辅助磁记录技术使用了矫顽力极高的材料,大大增加了数据的稳定性。一些莫名其妙的数据丢失、数据错误等问题将会大大减少。另外,高数据密度又会带来更大的容量。我们相信,只要解决好了散热、控制、加温等诸多问题后,热辅助磁记录技术的前景是非常看好的。根据目前的技术规划,热辅助磁记录技术开始可以达到大约5Tbit/平方英寸的数据存储密度,终甚至有望达到50Tbit/平方英寸,这个数据是目前垂直记录预计极限0.5Tbit/平方英寸的100倍。

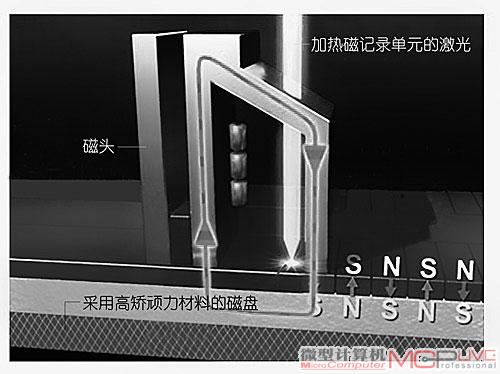

磁畴是什么?

磁畴是磁性材料内部的一个拥有独立磁方向的小区域。一块磁性物质内部有千千万万的磁畴,它们在没有被磁化的情况下,拥有表达自己不同磁性方向的权利。

磁畴示意图,在没有被磁化的情况下,磁畴的方向是随意的、散乱的。

所以整块磁铁在这种情况下是无磁性的。但在磁性物质被磁化后,所有的磁畴都被磁化向同一个方向,这样磁铁就能对外表示磁性了。

什么是顺磁和超顺磁效应

为了理解什么是超顺磁效应,我们先来解释什么是顺磁。顺,就是不反抗,顺磁,就是不反抗磁性。简而言之就是,这种材料是墙头草,在任何磁场中都能表现和磁场相同的磁性质。常见的、能被吸铁石吸住的铁片就是顺磁体。怎么才能顺磁呢?我们知道,如果将磁铁放在高温下烤,可以退磁。也就是说,磁铁在超过某个温度(被称作“居里温度”)后,它的磁性就消失了。如果磁体能在任何磁场中表现出和磁场相同方向的磁性,那么它就是顺磁体。超顺磁效应是指,磁体体积如果过小的话,磁体不能依靠自身稳定性来阻碍外部磁场的侵扰,那么此时超过体积临界值的小磁体将会表现出和顺磁体类似的性质。这就让科学家在缩小硬盘磁存储颗粒时遇到了麻烦。

给磁记录单元排座位——晶格介质记录技术

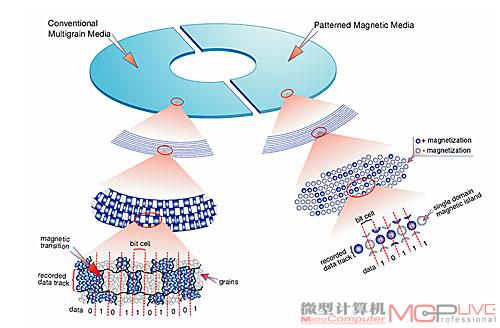

晶格介质记录技术,听起来很玄妙,实际上原理非常简单易懂。传统的磁记录方法在一整块磁性盘表面进行,所有的磁记录单元都是紧密靠在一起的。那么电脑怎么区分磁记录单元之间的区别呢?

从宏观角度来看,磁记录单元是一个一个表现出不同极性的点,在磁头飞过硬盘磁道时,会感知这些磁记录单元的信息,读取出如“SNNSNSNNSSN”这类信息,然后再翻译成“1”和“0”。从微观角度来看,这些紧靠在一起的磁记录单元之间的区分线并没有我们想象中的那样都是规整的直线。它们的“边界”像地图一样弯弯曲曲,看起来像是一块挤在一起的、能够表示出同样极性的“东西”。另外,传统硬盘的磁记录单元的体积都比较大,比如需要使用几十个磁畴、占据很大的面积才能保证数据稳定。

可以这样认为:目前的硬盘对磁记录单元的处理方式依旧属于“半粗放式”。硬盘对每一个磁记录单元的位置控制并不严格,只要在误差范围内即可。比如垂直记录技术,磁盘颗粒尺寸约为10nm,偏差范围在20%左右。用直观的数据来看,磁盘颗粒小有8nm的,大可以达到12nm。较大的磁记录单元体积,也能基本保证数据的稳定性。但要提高硬盘每平方英寸数据的密度,就必须降低磁记录单元的体积。这样又回到了上文的问题:存储的稳定性和有效性。在热辅助磁记录技术中,科学家使用了高矫顽力的材料。实际上还有一种方法可以既缩小磁记录单元体积,又保证数据的稳定性。

从技术本身来看,晶格介质技术和制造CPU的方法有些相似。首先,科学家会在制造硬盘的铝盘盘片表面涂上光阻剂,然后在光阻剂上用压印的方法形成很多微小孔,这些孔的尺寸甚至只有十几纳米。接下来,科学家用蚀刻的方法在盘片上腐蚀小孔,这些孔的深度有几纳米。后,对铝材表面进行氧化处理后,腐蚀出来的小孔深度会达到几百纳米,科学家在这一步会对小孔或者凸起的尖端进行处理,加入具有铁磁性的材料如钴,以及其它特殊的磁性稀土合金材料,终形成稳定无干扰的磁存储单元。当然,我们文中描述的只是晶格介质技术的一种实现方法。作为一个正在开发中的技术,科学家们会从不同的角度、使用不同的方法来解决问题。这些方法殊途同归:隔离、区分。

在电子显微镜下的晶格介质技术成品硬盘表面,会发现整齐的凸起和凹陷部分。每一个凹凸都代表了一个记录单元。

隔离每一个磁存储单元的效果是非常直接的:磁存储单元不用再害怕彼此之间的互相影响,超顺磁效应等都可能被控制在一个令人满意的幅度内。从另一个角度来看,晶格介质技术给硬盘一种新的发展思想—它不再用传统的多个小体积磁畴来存储数据,而使用单一的大体积磁畴,并将其置于相对孤立的“磁岛”上,大幅度降低了由于磁畴之间互相接触带来的影响。由于这种均匀的分隔设计,每一个磁存储单元的体积也会大幅度减小,空间将会被有效率的单元使用。一些规划中的数据表明,晶格介质技术会使用3~4nm的磁存储颗粒,它们的分布偏差少于5%,精确度更高。

这样一来,科学家就能使用更小的磁存储单元,从而大幅度提高硬盘的每平方英寸数据密度,根据目前的估计,采用晶格介质技术的硬盘甚至会高达每平方英寸50Tbit—大概在1元硬币那样的空间内就能够提供高达2TB的容量。这样的高容量足够应对未来很长一段时间内,硬盘对空间的需求。不过话说回来,晶格介质技术还存在很多问题,首要问题就是生产。目前的半导体制造技术还比较难以制造能满足5nm大小颗粒的沟槽。另外,对于硬盘这种同心圆排布的磁颗粒如何生产,也比较恼火,因为之前的半导体生产都是横平竖直的矩阵阵列,怎么样生产出圆形的、符合误差要求的沟槽和凸起,成为生产制造的首要难关。

春运和磁记录技术之间的关联

下面用一个例子来说明:我们知道,春运火车站前的广场往往人流攒动,几乎没有太多规律可循。现在,如果你把硬盘想象成春运火车站前广场,你就会发现很多相似的地方:火车站人挤人,乱哄哄—硬盘的磁存储之间会互相干扰;广场下雪了,大家都遭殃—磁存储单元脆弱,对温度敏感(越小越脆弱);广场上的警察和管理人员在维持秩序—磁头每次读写,都会重新施加磁场给这些存储单元,维持磁场秩序。

左侧是传统硬盘的磁记录方式,对磁记录单元的利用较为粗放;右侧是经过晶格介质技术重新整理排列的磁记录单元。

这主要是因为人和人之间没有太多限制,他们想去哪里就去哪里。如果为旅客划分隔离区域,建立一个临时“安置房”用于维持次序,那么那些踩踏、盗窃、拥挤等事故就不会发生,或者发生率大大将降低。好了,科学家准备为所有的磁存储单元建立隔离区域了。他们在硬盘表面丈量好“宅基地”,利用光刻技术造好“房子”,然后将磁存储单元一个一个放上去。为磁存储单元造房子,这就是晶格介质技术的原理。

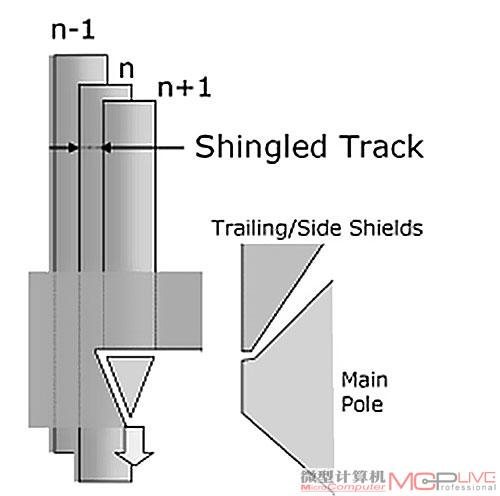

近在咫尺的技术——瓦记录

大家看到这个名字可能很奇怪,为什么要叫瓦记录呢?砖瓦和高科技的硬盘可一点都不搭边。但别忘了,我们之前介绍的技术核心都是尽可能地增大磁盘的利用率,在同样的面积上写入更多的信息。如果你自己观察一下屋顶瓦片的摆放方式,可能就会有不同的想法了。

瓦记录工作示意图,后写入的磁道恰好覆盖在前一次写入的磁道上。

瓦片在摆放时,总是重叠放置,终结果是瓦片本身的面积要远大于屋顶面积。其实这样的原理也可以应用在硬盘数据的读写上。硬盘存储数据的磁道,是一圈一圈的同心圆。从宏观角度来看,这些磁道的宽度是一定的。硬盘能存储多少数据,和磁道的宽度紧密相关。如果使用小体积的磁存储单元,磁道会变窄,同心圆的圈数就会增加,数据存储量就会增大,反之则数据存储量减少。

瓦记录是这样一种技术:它无需对现有的硬盘、磁头以及算法做出重大改进,不需要缩小记录磁头的宽度,只需要对磁头做出一些改进。主要是控制磁头的精确度,减少磁泄漏,增加屏蔽层即可。瓦记录技术在工作时,先在传统宽度的0磁道写入数据。等到0磁道写满,1磁道需要写入数据时,磁头并不从0磁道完全移开,反而有一部分覆盖在0磁道上,像瓦片那样一个覆盖另一个的一部分,然后写入1磁道,接下来2磁道也会覆盖一部分1磁道,直到将整个硬盘都写满。瓦记录技术由于磁头的特殊性,漏磁被降低到少,因此整个写入过程只会改变磁头覆盖部分的磁场,磁头没有覆盖到的部分,数据依旧完好。

瓦记录也存在一定问题,比如如果要更改某一磁道的数据,由于磁头的写入宽度没有变化,必将同时破坏另一个磁道的数据。怎样改变瓦记录磁道上的数据,是目前研究的一个难点问题。一旦某个文件分散在硬盘数个磁道上,瓦记录一次读写就可能牵涉到众多磁道。眼下比较好的解决办法是考虑大容量的缓存,用于存储读写中被破坏的数据。

瓦记录的优势在于它不像热辅助磁存储和晶格介质技术那样,需要彻底改变整个硬盘的生产方法,反而尽大可能利用了现有的设备,只需要做微小改动即可。但改进小也意味着容量提升空间不算大,瓦记录多可以提升数据存储密度到5Tbit/平方英寸,相比目前垂直记录极限的0.5Tbit/平方英寸提高了10倍。但考虑到瓦记录极低的成本,因此它有可能是下一代全新存储技术(热辅助磁存储技术和晶格介质等新技术)到来之前的过渡技术。

总结:技术有很多,希望在未来

硬盘的发展到今天已经过去了几十个年头。在这么漫长的时间中,很多技术被提出,又被淹没在历史中。目前热辅助磁记录技术、晶格介质技术和瓦记录,已经普遍被看好成为下一代甚至下下一代硬盘技术的候选者。除此之外,还有诸如微波辅助三维磁记录技术、二维磁记录技术等新的技术方案。这些技术并不是孤立存在的,它们之间很可能产生融合发展,各取其长。比如晶格介质技术就可能成为未来磁盘发展的基础性技术,在晶格介质技术的基础上再应用诸如微波辅助技术、热辅助技术等,这会为硬盘的进一步发展提供新的动力。

正如摩尔定律左右了晶体管的发展,克莱德法则和硬盘的发展也结下了不解之缘。克莱德法则认为,硬盘数据存储密度每13个月就要翻一番。虽然这个数据有点夸张,实际的增长速度在30%~40%左右。但作为一个良好的愿景,数据记录技术还大有潜力可挖。我们相信在不久的未来,克莱德法则会成为继摩尔定律后又一个经典发展定律,为人们思想和信息的存储立下汗马功劳。

MC特约评论员 林以诺(资深硬件玩家)

回顾PC开始进入家用领域的这十多年,早主流硬盘的容量为200MB~400MB;2010年,主流硬盘的容量为500GB~1TB。这期间,温彻斯特硬盘的容量增加了近2500倍。未来,借助热辅助磁记录技术与晶格介质记录技术,必将带来存储技术的又一次划时代革命。让我们共同期待更大、更快却更便宜的存储产品的出现吧。